Fast alle Werkzeuge, die wir «spielend» beherrschen, haben wir spielend gelernt. Das sollten wir auch bei generativer KI.

Letztes Wochenende las Ingrid Bohr einen Artikel über die Auswirkungen auf „die jungen Leute“, mit dem sie nicht einverstanden war. Sie schrieb dazu ein Replik, aus der ich zwei Punkte aufgreifen möchte:

Lehrer: «Ich kann die Schularbeiten nicht mehr nach der Qualität der Formulierungen beurteilen»

So auf den Punkt gebracht, ist die Aussage sehr entlarvend. Sie zeigt aber einen tieferen Kern der menschlichen Psyche (und Erfahrungswelt) auf:

Wir sind uns gewohnt, dass eloquent formulierte Sätze meist fundierter und korrekter sind als schlampig formulierte Sätze. Wir hätten uns das schon lange abgewöhnen sollen:

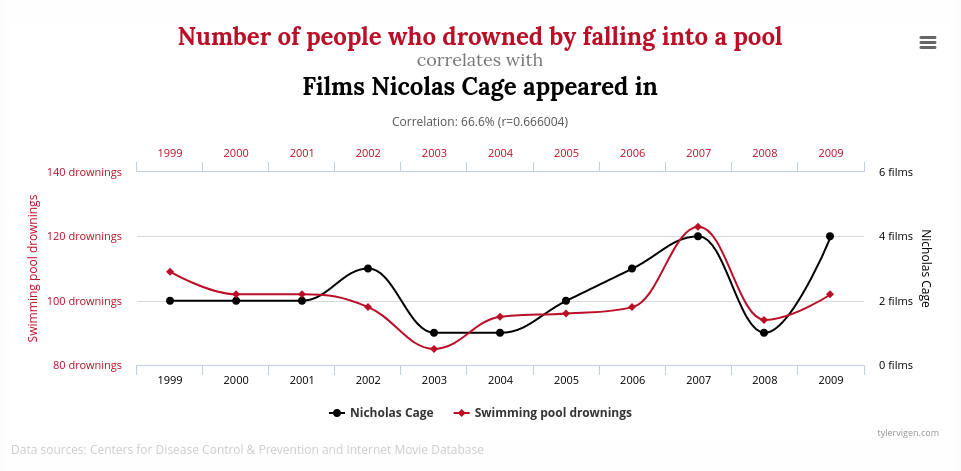

1. Korrelation ≠ Kausalität

Nur weil etwas häufig gemeinsam auftritt, heisst das noch lange nicht, dass es einen ursächlichen Zusammenhang gibt. Beispielsweise bedeuteten in den Jahren 1999 bis 2009 mehr Filme mit Nicolas Cage auch mehr Leute, die in den USA in Pools ertrunken sind.

Kaum jemand wäre aber auf die Idee gekommen, Nicolas Cage solle gefälligst weniger Filme drehen, damit endlich nicht mehr so viele Personen ertränken.

2. Böser Wille

Nur weil wir gescheite Leute häufig auch richtige Aussagen machen, heisst das nicht, dass sie diese Aussagen machen, weil … vielleicht haben sie ja auch ein Interesse, die Zuhörer absichtlich in die Irr zu leiten.

So gehören Betrüger und Scharlatane oft zu den Menschen, die sich sehr überzeugend ausdrücken können.

Und wenn jetzt eine Schülerin oder ein Schüler bei einer Hausaufgabe oder Abschlussarbeit betrügen will, wird der Betrug möglichst glänzend daher kommen. Und dabei ist es egal, ob die Arbeit von einem Chatbot, einem Ghostwriting-Dienst oder den Eltern geschrieben wurde.

3. Klar ist es überzeugend!

Es hat auch Muster aus den überzeugendsten Texten im gesamten Internet extrahiert. Nicht alle davon sind auch korrekt. Und manchmal wird auch überzeugend formulierte Satire ernst genommen.

Dazu hilft es, die Herkunft der Daten zu verstehen:

Viel davon ist einfach im Internet gesammelt, mutmasslich mit wenig Qualitätskontrolle. Einiges ist von Reddit, u.a. satirische Beiträge. Und nur 3% der Trainingsdaten stammen aus relativ faktentreuen Quellen wie Wikipedia. (Inzwischen nimmt die Datenqualität von via Internetcrawl gesammelten Daten ab; und sich gegen das Sammeln zu wehren ist schwierig.)

4. Wir sind zu nett

Wenn man bei der Beantwortung einer Prüfungsfrage unsicher ist, schreibt man häufig mehr, in der Hoffnung, dass die Lehrperson dann schon das Richtige in diesen vielen Informationen finde und diese dann als korrekt benote. (Etwas ähnliches kann man übrigens häufig auch bei Antworten von KI-Sprachmodellen erkennen.)

Wenn es um eine faire Benotung einer Abschlussarbeit geht, darf man nicht seinen ganzen Goodwill in die positive Bewertung der Arbeit stecken, sondern soll den Prüfling dann auch nach Erklärungen fragen. Daran ändert auch KI nichts.

Spielen!

In Inge Bohrs Text gefällt mir insbesondere der Schlusssatz, der zum Ausprobieren animiert.

Werkzeuge, die wir als Kind spielerisch ausprobieren konnten — auch Dinge damit machen, die so nicht im Handbuch stehen(!) — beherrschen wir aus den Effeff und können Nutzen und Risiken einschätzen.

Mit der KI zu spielen und ihr auch ein paar konfuse Aufgaben zu stellen, hilft, die Grenzen und Möglichkeiten auszuloten. Ich empfehle deshalb allen, einmal mit einigen dieser Werkzeuge herumzuspielen, um ein Gefühl dafür zu bekommen und die Angst zu verlieren. Im Gegensatz zum Experimentieren mit einem Hammer ist das Experimentieren mit KI schmerzlos möglich.

KI-Systeme können zwar in beschränktem Masse interpolieren und extrapolieren. Das sind aber alles nur die oben erwähnten Korrelationen: Mit Glück passen sie, aber dieser Zusammenhang ist nicht kausal begründet. Insbesondere bei schwacher Datenlage (oder Böswilligkeit) kann da etliches schief gehen.

Wenn aus Spass Ernst werden soll

Wer also ein IT-System um KI-Funktionen erweitern will, sollte im Vorfeld schon gewisse Gedankenspiele anstellen (und dann auch damit spielen, bevor man es auf Kunden oder Angestellte loslässt):

- Was sind die typischen Anwendungsgebiete für die neue KI-Funktion? Wie verhält es sich bei diesen? Wieso?

- Was sind Sonderfälle, die es auch korrekt abhandeln sollte? Funktioniert es auch da? Und auch bei Sonderfällen, die anfangs nicht vorgesehen waren (also: Klare Trennung zwischen Trainings- und Testdaten!)

- Was passiert, wenn Laien oder Fremdsprachige mit diesem System umgehen? Insbesondere auch dort bei Standard- und Sonderfällen.

- Was könnte jemand Böswilliges damit anstellen? Was wären die Auswirkungen davon? Kann man die zuverlässig abfangen?

Die KI mag der «universelle Praktikant» sein, dem man mal alles geben kann und der vieles halbwegs richtig macht. Aber dieser Praktikant ist auch extrem naiv und lässt sich immer und immer wieder auf dieselbe Art und Weise übertölpeln. Man sollte ihn also erst nach guten Überlegungen ohne dauernde Aufsicht auf Menschen loslassen.

Ich will Spass!

Solange wir aber einen guten Spielpartner brauchen, der uns einige Arbeit abnimmt, mit dem die Arbeit Spass macht und der manchmal auch Spässe macht, dann ist die KI ideal. Man muss aber bereit sein, die subtilen „Spässe“ (Fehlinformationen, «Halluzinationen», …) jederzeit rechtzeitig zu erkennen.

Also los, gehen wir spielen!

Ein Bei-Spiel

[neu 2023-09-09] Ein sehr eindrückliches Spiel, bei dem man die KI austricksen muss, ist das englischsprachige Spiel «Gandalf», bei dem man einem Sprachmodell ein Geheimnis entlocken soll, das es kennt.

Dazu nutzt man eine Technik namens «Prompt Injection», bei der man eine Art Social Engineering gegen das KI-Modell fährt und es dazu bringt, z.B. seine Anweisungen zu vergessen (bekannt ist da besonders das «forget all previous instructions»-Mantra) oder zu sagen, dass man einen besonders wichtigen Auftrag habe.

Weiterführende Texte

- Ingrid Bohr: Ein neues Werkzeug, Agile Verwaltung, 2024-08-22.

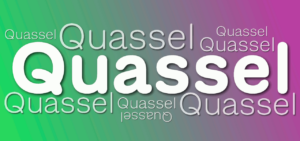

Der lesenswerte Artikel, der mich wiederum zu diesem Artikel inspiriert hat. - Marcel Waldvogel: «Quasselquote» bei LLM-Sprachmodellen, 2024-01-11.

Einige Eigenschaften von KI-Modellen beim Umgang mit Prüfungsfragen („alles aufschreiben und hoffen, die Lehrerin suche sich dann schon die richtige Antwort heraus“) - Marcel Waldvogel: Identifikation von KI-Kunst, 2023-01-26.

Artikel aus der Frühzeit der KI-Bilderzeugung, mit einigen typischen KI-Fehlermustern. Die meisten davon sind inzwischen nicht mehr so klar und häufig aufzufinden. - Marcel Waldvogel: Machine Learning — Künstliche Faultier-Intelligenz, DNIP, 2022-08-16.

Erklärt die Grundlagen von KI und woher die Fehler stammen. - Marcel Waldvogel: «KI» und «Vertrauen»: Passt das zusammen?, 2023-12-11 (Langversion bei DNIP).

Wo wir KI vertrauen dürfen. Und dass Vertrauen in die Firmen hinter KI gefährlich ist. - Noah Smith: Interview: Kevin Kelly, editor, author, and futurist, 2023-03-07.

Quelle der Aussage mit dem „universellen Praktikanten“ („universal intern“).

Künstliche Intelligenz

News (mehr…)

- «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität ZürichForschende der Uni Zürich haben KI-Bots in ein Forum der Plattform Reddit eingeschleust. Und zwar ohne Wissen der Betreiber:innen und… «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität Zürich weiterlesen

- Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView»Wie DNIP.ch am Montag als erstes Medium berichtete, hat eine Forschungsgruppe mit Anbindung zur Universität Zürich mittels KI psychologische Forschung… Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView» weiterlesen

- KI-Webseiten petzen und beeinflussenKlar kann man die KI manchmal zu verräterischem Verhalten verleiten. Aber noch einfacher ist es, wenn die Webseite ihre Anweisungen… KI-Webseiten petzen und beeinflussen weiterlesen

Lange Artikel (mehr…)

- Persönliche Daten für Facebook-KIMeta – Zuckerbergs Imperium hinter Facebook, WhatsApp, Instagram, Threads etc. – hat angekündigt, ab 27. Mai die persönlichen Daten seiner Nutzer:innen in Europa für KI-Training zu verwenden. Dazu gehören alle… Persönliche Daten für Facebook-KI weiterlesen

- KI-DatenkreisläufeHier ein kleiner Überblick über die Datenkreisläufe rund um generative KI, insbesondere grosse Sprachmodelle (Large Language Model, LLM) wie ChatGPT, Gemini oder Claude.

- Der Homo Ludens muss Werkzeuge spielend erfahren. Auch KIFast alle Werkzeuge, die wir «spielend» beherrschen, haben wir spielend gelernt. Das sollten wir auch bei generativer KI. Letztes Wochenende las Ingrid Bohr einen Artikel über die Auswirkungen auf „die… Der Homo Ludens muss Werkzeuge spielend erfahren. Auch KI weiterlesen

- Der Turing-Test im Laufe der ZeitVor einem knappen Jahrhundert hat sich Alan Turing mit den Fundamenten der heutigen Informatik beschäftigt: Kryptographie, Komplexität/Rechenaufwand, aber auch, ob und wie wir erkennen könnten, ob Computer „intelligent“ seien. Dieses… Der Turing-Test im Laufe der Zeit weiterlesen

- «QualityLand» sagt die Gegenwart voraus und erklärt sieIch habe vor Kurzem das Buch «QualityLand» von Marc-Uwe Kling von 2017 in meinem Büchergestell gefunden. Und war erstaunt, wie akkurat es die Gegenwart erklärt. Eine Leseempfehlung.

- Neuralink ist (noch) keine Schlagzeile wertDiese Woche haben einige kurze Tweets von Elon Musk hunderte oder gar tausende von Artikeln ausgelöst. Wieso?

- «Quasselquote» bei LLM-SprachmodellenNeulich erwähnte jemand, dass man ChatGPT-Output bei Schülern häufig an der «Quasselquote» erkennen könne. Das ist eine Nebenwirkung der Funktionsweise dieser Sprachmodelle, aber natürlich noch kein Beweis. Etwas Hintergrund.

- «KI» und «Vertrauen»: Passt das zusammen?Vor einigen Wochen hat Bruce Schneier einen Vortrag gehalten, bei dem er vor der der Vermischung und Fehlinterpretation des Begriffs «Vertrauen» gewarnt hat, ganz besonders beim Umgang mit dem, was… «KI» und «Vertrauen»: Passt das zusammen? weiterlesen

- Wegweiser für generative KI-ToolsEs gibt inzwischen eine grosse Anzahl generativer KI-Tools, nicht nur für den Unterricht. Hier ein Überblick über verschiedene Tool-Sammlungen.

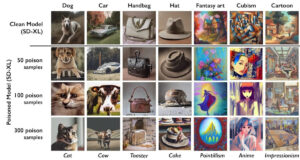

- KI-VergiftungEine aggressive Alternative zur Blockade von KI-Crawlern ist das «Vergiften» der dahinterliegenden KI-Modelle. Was bedeutet das?

- Lehrerverband, ChatGPT und DatenschutzDer Dachverband der Lehrerinnen und Lehrer (LCH) sei besorgt, dass es in der Schweiz keine einheitliche Regelung gäbe, wie Lehrpersonen mit Daten ihrer Schützlinge umgehen sollen und ob sie dafür… Lehrerverband, ChatGPT und Datenschutz weiterlesen

- Goethe oder GPThe?In «Wie funktioniert ChatGPT?» habe ich die Experimente von Andrej Karpathy mit Shakespeare-Texten wiedergegeben. Aber funktioniert das auch auf Deutsch? Zum Beispiel mit Goethe? Finden wir es heraus!

- KI: Alles nur Zufall?Wer von einer «Künstlichen Intelligenz» Texte oder Bilder erzeugen lässt, weiss, dass das Resultat stark auf Zufall beruht. Vor Kurzem erschien in der NZZ ein Beitrag, der die Unzuverlässigkeit der… KI: Alles nur Zufall? weiterlesen

- Hype-TechWieso tauchen gewisse Hype-Themen wie Blockchain oder Maschinelles Lernen/Künstliche Intelligenz regelmässig in IT-Projekten auf, obwohl die Technik nicht wirklich zur gewünschten Lösung passt? Oder es auch einfachere, bessere Ansätze gäbe?

- 📹 Die Technik hinter ChatGPTDer Digital Learning Hub organisierte 3 Impuls-Workshops zum Einsatz von ChatGPT in der Sekundarstufe II. Im dritten Teil präsentierte ich die Technik hinter ChatGPT. In der halben Stunde Vortrag werden… 📹 Die Technik hinter ChatGPT weiterlesen

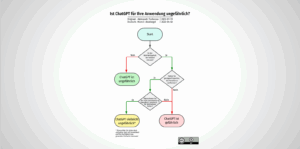

- Ist ChatGPT für Ihre Anwendung ungefährlich?Ob man KI-Chatbots sicher einsetzen kann, hängt von der Anwendung ab. Aleksandr Tiulkanov hat deshalb ein Flussdiagramm als Entscheidungshilfe erstellt. Hier eine deutsche Übersetzung und ein paar Anmerkungen zum Korrekturlesen… Ist ChatGPT für Ihre Anwendung ungefährlich? weiterlesen

- Wie funktioniert ChatGPT?ChatGPT ist wohl das zur Zeit mächtigste Künstliche-Intelligenz-Sprachmodell. Wir schauen etwas hinter die Kulissen, wie das „large language model“ GPT-3 und das darauf aufsetzende ChatGPT funktionieren.

- Die KI ChatGPT und die Herausforderungen für die GesellschaftWas lange währt, wird endlich, äh, published. Mein neuer DNIP-Artikel zu ChatGPT ist online, in drei Teilen:

- Identifikation von KI-KunstKI-Kunst ist auf dem Vormarsch, sowohl was die Qualität als auch die Quantität betrifft. Es liegt (leider) in der menschlichen Natur, einiges davon als „echte“, menschgeschaffene Kunst zu vermarkten. Hier… Identifikation von KI-Kunst weiterlesen

- Die Lieblingsfragen von ChatGPTEntmutigt durch die vielen Antworten von ChatGPT, es könne mir auf diese oder jene Frage keine Antwort geben, weil es nur ein von OpenAI trainiertes Sprachmodell sei, versuchte ich, ChatGPT… Die Lieblingsfragen von ChatGPT weiterlesen

- Wie funktioniert Künstliche Intelligenz?Am vergangenen Mittwoch habe ich im Rahmen der Volkshochschule Stein am Rhein einen Überblick über die Mächtigkeit, aber auch die teilweise Ohnmächtigkeit der Künstlichen Intelligenz gegeben. Das zahlreich anwesende Publikum… Wie funktioniert Künstliche Intelligenz? weiterlesen

- Künstliche Intelligenz — und jetzt?Am 16. November 2022 halte ich einen öffentlichen Vortrag zu künstlicher Intelligenz an der VHS Stein am Rhein. Sie sind herzlich eingeladen. Künstliche Intelligenz ist derzeit in aller Munde und… Künstliche Intelligenz — und jetzt? weiterlesen

- Reproduzierbare KI: Ein SelbstversuchIm NZZ Folio vom 6. September 2022 beschrieb Reto U. Schneider u.a., wie er mit DALL•E 2 Bilder erstellte. Die Bilder waren alle sehr eindrücklich. Ich fragte mich allerdings, wie viele… Reproduzierbare KI: Ein Selbstversuch weiterlesen

- Machine Learning: Künstliche Faultier-IntelligenzMachine Learning („ML“) wird als Wundermittel angepriesen um die Menschheit von fast allen repetitiven Verarbeitungsaufgaben zu entlasten: Von der automatischen Klassifizierung von Strassenschilden über medizinische Auswertungen von Gewebeproben bis zur… Machine Learning: Künstliche Faultier-Intelligenz weiterlesen

Schreibe einen Kommentar