Vor einem knappen Jahrhundert hat sich Alan Turing mit den Fundamenten der heutigen Informatik beschäftigt: Kryptographie, Komplexität/Rechenaufwand, aber auch, ob und wie wir erkennen könnten, ob Computer „intelligent“ seien.

Dieses Imitationsspiel kennen wir heute als Turing-Test und ist aktuell wieder in aller Munde, weil gerade behauptet wird, dass Computer inzwischen intelligenter seien als Menschen. Er hat sich über die Jahre stark verändert und zeigt damit auch auf, wie sich unsere Beziehung zu Computern verändert hat.

Schauen wir uns das an und lernen etwas über uns (und Computer)!

Eine überarbeitete und erweiterte Fassung dieses Textes erschien bei DNIP unter dem Titel «Was der Turing-Test für die Gesellschaft bedeutet».

Die traditionelle Erzählung

The Imitation Game (Turing, 1950)

Im ursprünglichen Test sollte ein Proband mit zwei Personen schriftlich kommunizieren und herausfinden, wer von seinen Kommunikationspartnern ein Mann und wer eine Frau sei. Ohne Wissen des Probanden wird allerdings der Mann durch einen Computer ersetzt, der nun den Probanden über seine Menschlichkeit erfolgreich täuschen soll. (Mehr dazu hier.)

In diesem Setup ist ein komplettes Verständnis für das menschliche Wissen, Gesellschaft und Werte notwendig. (Und über Täuschung, was einer der Kritikpunkte am Test ist.)

Heutiger Turing-Test

Weil das zu komplex war, wurde der Test vereinfacht. Der Proband kommuniziert über Tastatur und Bildschirm mit zwei Gesprächspartnern: Ein Mensch, eine Maschine. Wenn der Proband nach intensiver Befragung seiner Gegenüber nicht entscheiden kann, wer Mensch, wer Maschine ist, wird der Maschine ein dem Menschen ebenbürtiges (Denk-)Vermögen unterstellt.

Entwicklungen

Auch auf Basis dieser Überlegungen begannen Anstrengungen, Maschinen (bzw. Programme) zu erzeugen, welche den Menschen imitieren konnten. Die Idee der Künstlichen Intelligenz war geboren.

- Ein erster Meilenstein gelang Joseph Weizenbaum 1966 mit seinem Programm «Eliza», welches natürlichsprachige Interaktion erlaubte. Die Interaktion war rudimentär. Hauptsächlich hat das Programm im menschlichen Satz nach Schlüsselwörtern gesucht und daraus geeignete scheinende Rückfragen erstellt. Trotz dieser Einfachheit kann man sich über einige Sätze hinweg mit dem „Gegenüber“ unterhalten, bis auffällt, dass die Gegenseite sehr eintönig (und manchmal einfältig) reagiert. Eine grafisch sehr ansprechende Simulation des Eliza-Feelings gibt es bei Masswerk zu erleben. Oder hier eine deutsche Variante (mit eingeschränktem Wortschatz).

- Es war sehr aufwändig, die ganzen Regeln von Hand aufzustellen, nach denen diese Expertensysteme Antworten auf Fragen liefern sollten. Informatiker haben den Ruf, sich vor repetitiven Arbeiten zu drücken. Deshalb haben sie mutmasslich das Maschinelle Lernen erfunden, eine Technik, in der der Computer selbst die Regeln herausfinden soll.

- Daraus sind dann später die heutigen Large Language Models (LLM, grosse Sprachmodelle) entstanden wie z.B. ChatGPT, die auf selbst erarbeiteten Statistiken zu Wort-, Satz- und grösseren Mustern beruhen.

Aktuelle Erfolge

In verschiedenen Medien wurde vor einigen Wochen berichtet, dass ChatGPT den Turing-Test bestanden habe. Patrick Seemann hat dies für DNIP zusammengefasst und blickt hinter die Kulissen. Seine Schlussfolgerungen:

- Es hat einen sehr umfangreichen Prompt mit 130 Zeilen Text gebraucht, um einen Rahmen für weitgehend belanglose Gespräche zu definieren.

- Mit etwas Aufwand lässt sich ChatGPT durch gezielte Fragen zumindest in die Enge treiben (auch wenn der Prompt dafür sorgt, dass der Bot nicht direkt zugibt, ein Bot zu sein), auch wenn das in den Selbstversuchen teilweise länger als die Experimentdauer gebraucht hat.

- 22% der Probanden haben selbst den sehr simplen Eliza-Chatbot als Menschen wahrgenommen, es scheint also einen nicht zu vernachlässigen Teil der Bevölkerung zu geben, welcher solchen Chats gegenüber relativ unkritisch ist oder im Alltag genau diese Art von Chats führt.

- Es ist unklar, inwieweit die Teilnehmenden motiviert waren, den Chat-Partner ernsthaft zu identifizieren bzw. wie ernst sie das ganze überhaupt genommen haben.

Eine weitere Frage ist, ob wir überhaupt zwischen Mensch und Computer als Gegenüber unterscheiden können müssen. (Ich behaupte «ja»; mehr dazu in einigen Tagen auf DNIP.ch.)

Der andere Blickwinkel

Das Imitation Game von Alan Turing war ja ursprünglich sehr umfassend, wurde dann aber recht schnell auf Intelligenz eingeschränkt. Aber inzwischen bewegt sich die Definition wieder mehr auf das ursprüngliche Bild von Turing 1950 zurück. Oder wie die angelsächsischen Kollegen sagen würden: «It has come full circle.»

Kriterium 1: Intelligenz

Der altbekannte Ansatz war: «Der Computer soll uns beweisen, dass er intelligent ist!»

Aber dann kamen Schachcomputer und Watson, der beim Wissensquiz Jeopardy gewann. Der menschliche Intellekt war zwiegespalten: Auf der einen Seite sind Computer jetzt besser als wir. Auf der anderen Seite sind wir aber die Schöpfer dieser unglaublichen „Geschöpfe“!

Gleichzeitig begannen Computer «zurückzuschlagen», uns Menschen auf die Probe zu stellen: Seither müssen wir beweisen, dass wir keine Computer sind, indem wir auf absichtlich verrauschte Bilder klicken.

Nicht nur hat uns der Computer geschlagen, „er“ begann im Gegenzug, uns Arbeit aufzuhalsen. Das hat also schon einmal gar nicht funktioniert.

Kriterium 2: Mitgefühl

Also war eine bessere Idee gefragt: «Der Computer soll uns beweisen, dass er Mitgefühl hat!» (oder zumindest dieses Mitgefühl überzeugend simulieren).

Aber dann kamen LLMs wie ChatGPT, grosse Sprachmodelle, die beliebig Sätze und Satzmuster aus allen menschlichen Äusserungen kombinieren konnten. Einige dieser generierten Muster („Antworten“) waren liebevoll, einige hilfreich, einige völlig falsch oder am Thema vorbei. Wieder andere aber auch hässlich, grausam, beleidigend, drohend.

Die Firmen hinter den KIs wollten sich aber nicht blamieren (oder verklagen lassen) und haben entsprechend ihre KIs gezähmt.

Kriterium 3: Ungezähmt

Deshalb kam die nächste Idee auf: «Dann soll uns der Computer doch einmal beweisen, dass er böse oder lüstern sein kann!»

An der Weigerung, ungezügelten Text zu produzieren, kann man immer noch viele kommerzielle Chatbots erkennen. Aber es gibt inzwischen auch unzählige Chatbots, die genau dafür „gezüchtet“ wurden, frech oder lüstern zu agieren. Eine Herstellerin von KI-Ersatzfreundinnen wurde sogar öffentlich dafür gerügt, als diese KI-„Freundinnen“ irgendwann weniger sexuell expliziten Dialog ermöglichten (und musste den Chatbot auf Druck der User kurze Zeit später wieder in der „bewährten“ Erotikstufe verfügbar machen).

Also ist auch dieses Kriterium inzwischen wieder Geschichte. Auch wenn es gegen viele seriöse Chatbots weiterhin funktioniert.

Kriterium 4: Äh, ja, was nun?

Eine einfache Lösung scheint es nicht zu geben, wie wir bei einem Gegenüber zwischen Mensch und KI unterscheiden können. Hier ein paar Fragen, die wir uns stellen sollten:

- Ist es mir wichtig, das Gegenüber zu identifizieren? Wieso? (Aufbau einer gegenseitigen Beziehung, Einschätzung der Vertrauenswürdigkeit, …)

- Reicht es mir, wenn ich weiss, was das Gegenüber leisten kann? Was zuverlässig, was weniger zuverlässig, was gar nicht?

- Will ich echte Empathie? Reicht mir auch eine überzeugend Vorgetäuschte (Empathie vortäuschen können auch Menschen)?

- Will ich eine echte menschliche Leistung dahinter?

- Will ich echte X (was auch immer mein X ist)? Oder reicht mir eine Annäherung daran?

- Wenn ich das Gegenüber bezahle (mit Geld oder Daten): Will ich, dass ich weiss, wohin diese Bezahlung fliesst?

Weiterführende Literatur

- Patrick Seemann: ChatGPT besteht den Turing-Test, gilt KI jetzt als intelligent?, DNIP, 2024-07-15.

Lesenswerter Überblick über die ganze Turing-Test-Geschichte - Zoe Stavri aka Another Angry Woman: If you are human, answer me this, 2023-11-05.

Motivation für die Liste mit der Entwicklung der Tests (Teile des Threads sind NSFW) - Marcel Waldvogel: Marcel pendelt: «KI» und «Vertrauen», DNIP, 2023-12-11.

Überlegungen von Bruce Schneier, ob wir KI überhaupt vertrauen können, insbesondere kommerziellen KIs

Künstliche Intelligenz

News (mehr…)

- «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität ZürichForschende der Uni Zürich haben KI-Bots in ein Forum der Plattform Reddit eingeschleust. Und zwar ohne Wissen der Betreiber:innen und… «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität Zürich weiterlesen

- Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView»Wie DNIP.ch am Montag als erstes Medium berichtete, hat eine Forschungsgruppe mit Anbindung zur Universität Zürich mittels KI psychologische Forschung… Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView» weiterlesen

- KI-Webseiten petzen und beeinflussenKlar kann man die KI manchmal zu verräterischem Verhalten verleiten. Aber noch einfacher ist es, wenn die Webseite ihre Anweisungen… KI-Webseiten petzen und beeinflussen weiterlesen

Lange Artikel (mehr…)

- Persönliche Daten für Facebook-KIMeta – Zuckerbergs Imperium hinter Facebook, WhatsApp, Instagram, Threads etc. – hat angekündigt, ab 27. Mai die persönlichen Daten seiner Nutzer:innen in Europa für KI-Training zu verwenden. Dazu gehören alle… Persönliche Daten für Facebook-KI weiterlesen

- KI-DatenkreisläufeHier ein kleiner Überblick über die Datenkreisläufe rund um generative KI, insbesondere grosse Sprachmodelle (Large Language Model, LLM) wie ChatGPT, Gemini oder Claude.

- Der Homo Ludens muss Werkzeuge spielend erfahren. Auch KIFast alle Werkzeuge, die wir «spielend» beherrschen, haben wir spielend gelernt. Das sollten wir auch bei generativer KI.

- Der Turing-Test im Laufe der ZeitVor einem knappen Jahrhundert hat sich Alan Turing mit den Fundamenten der heutigen Informatik beschäftigt: Kryptographie, Komplexität/Rechenaufwand, aber auch, ob und wie wir erkennen könnten, ob Computer „intelligent“ seien. Dieses… Der Turing-Test im Laufe der Zeit weiterlesen

- «QualityLand» sagt die Gegenwart voraus und erklärt sieIch habe vor Kurzem das Buch «QualityLand» von Marc-Uwe Kling von 2017 in meinem Büchergestell gefunden. Und war erstaunt, wie akkurat es die Gegenwart erklärt. Eine Leseempfehlung.

- Neuralink ist (noch) keine Schlagzeile wertDiese Woche haben einige kurze Tweets von Elon Musk hunderte oder gar tausende von Artikeln ausgelöst. Wieso?

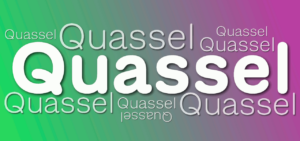

- «Quasselquote» bei LLM-SprachmodellenNeulich erwähnte jemand, dass man ChatGPT-Output bei Schülern häufig an der «Quasselquote» erkennen könne. Das ist eine Nebenwirkung der Funktionsweise dieser Sprachmodelle, aber natürlich noch kein Beweis. Etwas Hintergrund.

- «KI» und «Vertrauen»: Passt das zusammen?Vor einigen Wochen hat Bruce Schneier einen Vortrag gehalten, bei dem er vor der der Vermischung und Fehlinterpretation des Begriffs «Vertrauen» gewarnt hat, ganz besonders beim Umgang mit dem, was… «KI» und «Vertrauen»: Passt das zusammen? weiterlesen

- Wegweiser für generative KI-ToolsEs gibt inzwischen eine grosse Anzahl generativer KI-Tools, nicht nur für den Unterricht. Hier ein Überblick über verschiedene Tool-Sammlungen.

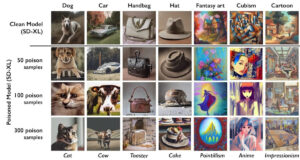

- KI-VergiftungEine aggressive Alternative zur Blockade von KI-Crawlern ist das «Vergiften» der dahinterliegenden KI-Modelle. Was bedeutet das?

- Lehrerverband, ChatGPT und DatenschutzDer Dachverband der Lehrerinnen und Lehrer (LCH) sei besorgt, dass es in der Schweiz keine einheitliche Regelung gäbe, wie Lehrpersonen mit Daten ihrer Schützlinge umgehen sollen und ob sie dafür… Lehrerverband, ChatGPT und Datenschutz weiterlesen

- Goethe oder GPThe?In «Wie funktioniert ChatGPT?» habe ich die Experimente von Andrej Karpathy mit Shakespeare-Texten wiedergegeben. Aber funktioniert das auch auf Deutsch? Zum Beispiel mit Goethe? Finden wir es heraus!

- KI: Alles nur Zufall?Wer von einer «Künstlichen Intelligenz» Texte oder Bilder erzeugen lässt, weiss, dass das Resultat stark auf Zufall beruht. Vor Kurzem erschien in der NZZ ein Beitrag, der die Unzuverlässigkeit der… KI: Alles nur Zufall? weiterlesen

- Hype-TechWieso tauchen gewisse Hype-Themen wie Blockchain oder Maschinelles Lernen/Künstliche Intelligenz regelmässig in IT-Projekten auf, obwohl die Technik nicht wirklich zur gewünschten Lösung passt? Oder es auch einfachere, bessere Ansätze gäbe?… Hype-Tech weiterlesen

- 📹 Die Technik hinter ChatGPTDer Digital Learning Hub organisierte 3 Impuls-Workshops zum Einsatz von ChatGPT in der Sekundarstufe II. Im dritten Teil präsentierte ich die Technik hinter ChatGPT. In der halben Stunde Vortrag werden… 📹 Die Technik hinter ChatGPT weiterlesen

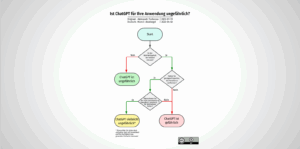

- Ist ChatGPT für Ihre Anwendung ungefährlich?Ob man KI-Chatbots sicher einsetzen kann, hängt von der Anwendung ab. Aleksandr Tiulkanov hat deshalb ein Flussdiagramm als Entscheidungshilfe erstellt. Hier eine deutsche Übersetzung und ein paar Anmerkungen zum Korrekturlesen… Ist ChatGPT für Ihre Anwendung ungefährlich? weiterlesen

- Wie funktioniert ChatGPT?ChatGPT ist wohl das zur Zeit mächtigste Künstliche-Intelligenz-Sprachmodell. Wir schauen etwas hinter die Kulissen, wie das „large language model“ GPT-3 und das darauf aufsetzende ChatGPT funktionieren.

- Die KI ChatGPT und die Herausforderungen für die GesellschaftWas lange währt, wird endlich, äh, published. Mein neuer DNIP-Artikel zu ChatGPT ist online, in drei Teilen:

- Identifikation von KI-KunstKI-Kunst ist auf dem Vormarsch, sowohl was die Qualität als auch die Quantität betrifft. Es liegt (leider) in der menschlichen Natur, einiges davon als „echte“, menschgeschaffene Kunst zu vermarkten. Hier… Identifikation von KI-Kunst weiterlesen

- Die Lieblingsfragen von ChatGPTEntmutigt durch die vielen Antworten von ChatGPT, es könne mir auf diese oder jene Frage keine Antwort geben, weil es nur ein von OpenAI trainiertes Sprachmodell sei, versuchte ich, ChatGPT… Die Lieblingsfragen von ChatGPT weiterlesen

- Wie funktioniert Künstliche Intelligenz?Am vergangenen Mittwoch habe ich im Rahmen der Volkshochschule Stein am Rhein einen Überblick über die Mächtigkeit, aber auch die teilweise Ohnmächtigkeit der Künstlichen Intelligenz gegeben. Das zahlreich anwesende Publikum… Wie funktioniert Künstliche Intelligenz? weiterlesen

- Künstliche Intelligenz — und jetzt?Am 16. November 2022 halte ich einen öffentlichen Vortrag zu künstlicher Intelligenz an der VHS Stein am Rhein. Sie sind herzlich eingeladen. Künstliche Intelligenz ist derzeit in aller Munde und… Künstliche Intelligenz — und jetzt? weiterlesen

- Reproduzierbare KI: Ein SelbstversuchIm NZZ Folio vom 6. September 2022 beschrieb Reto U. Schneider u.a., wie er mit DALL•E 2 Bilder erstellte. Die Bilder waren alle sehr eindrücklich. Ich fragte mich allerdings, wie viele… Reproduzierbare KI: Ein Selbstversuch weiterlesen

- Machine Learning: Künstliche Faultier-IntelligenzMachine Learning („ML“) wird als Wundermittel angepriesen um die Menschheit von fast allen repetitiven Verarbeitungsaufgaben zu entlasten: Von der automatischen Klassifizierung von Strassenschilden über medizinische Auswertungen von Gewebeproben bis zur… Machine Learning: Künstliche Faultier-Intelligenz weiterlesen

Schreibe einen Kommentar