Eine aggressive Alternative zur Blockade von KI-Crawlern ist das «Vergiften» der dahinterliegenden KI-Modelle. Was bedeutet das?

Viele Daten aus Webseiten, Büchern und Grafiken sind bereits in die KI-Modelle geflossen. Ob dies urheberrechtskonform geschehen ist und was das für daraus generierte Outputs bedeutet: Das ist immer noch ein juristisch unklares Feld. Aktuell scheint die Devise zu sein: «Move fast and break things».

Aber einige der generativen KIs bieten Webseitenbetreibern inzwischen die Möglichkeit, den Fluss zusätzlicher Daten an ihre KI-Modelle einzuschränken.

Einigen Künstlern (und Wissenschaftlern) scheint das nicht zu gefallen, sie wollen mehr. Vielleicht sogar sowas wie Rache. Und daher:

Wie vergifte ich eine KI?

Machen wir das doch Schritt für Schritt:

Was macht der Urheber?

- Ein Urheber, nennen wir ihn Urs, hat ein grafisches Werk geschaffen (Foto, Bild, …).

- Urs will das Werk vielleicht sogar ins Internet stellen. Er hat aber keine Lust, es generativen Bild-KIs wie DALL•E, StableDiffusion oder MidJourney zur Verfügung zu stellen.

- Urs vertraut nicht darauf, dass die Crawler dieser generativen KIs das Bild auf seiner Webseite oder anderswo nicht doch indexieren.

- Er ist aber bereit, für seine Internet-Repräsentation des Werks eine kleine Qualitätseinbusse hinzunehmen.

- Er nutzt einen Software, welche sein Bild mit einem leichten Rauschen unterlegt, mit dem Zweck, dass die Lernmechanismen der KIs dieses Bild dann als etwas anderes erkennen (wie hier: Da wird ein Faultier unmerklich so modifiziert, dass die ML-Klassifikation es nachher als Rennauto zu erkennen glaubt).

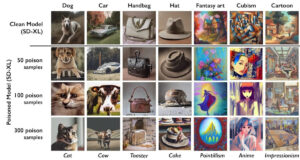

Beispielsweise kann eine Katze so modifiziert werden, dass sie als Hund erkannt würde.

Was macht das KI-System beim Lernen?

Für jedes vom Crawler gefundene Bild lauft (sehr vereinfacht) eine Variante dieses Workflows ab:

- Das Bild bzw. Teile davon werden an eine Bilderkennungssoftware (auf Basis von Maschinellem Lernen) weitergegeben.

- Diese Bilderkennungssoftware versieht das Bild mit Labeln, welche die erkannten Objekte bezeichnen („labelling“).

- Die so gelabelten Ausschnitte werden als paar trainiert.

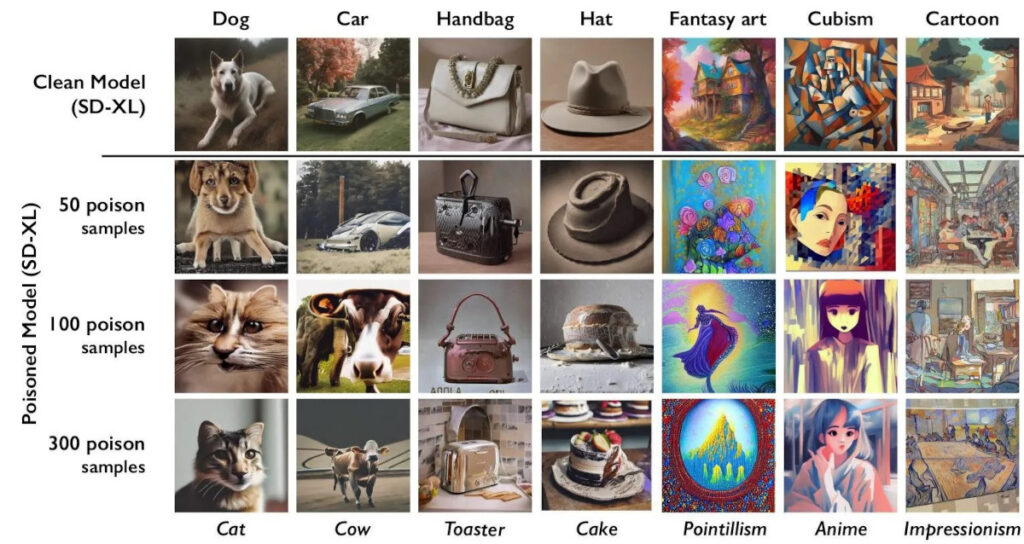

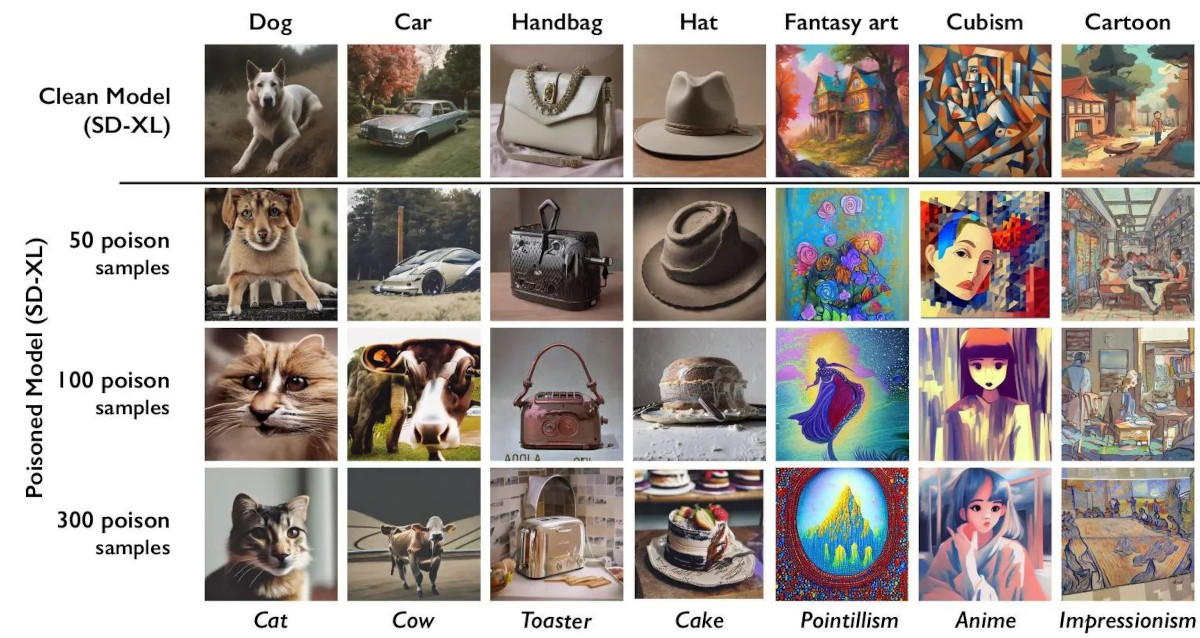

Wenn die Katze als Hund erkannt wird, wird ihr Bild mit den Bildern aller Hunde vermischt, d.h. das Modell hat dann in seinem mit „Hund“ betitelten Bereich sowohl Bilder von Hunden als auch von Katzen.

Was macht das KI-System beim Generieren von Bildern?

- Wenn ein bestimmtes Objekt gewünscht ist (beispielsweise ein Hund), werden die Muster aus dem mit entsprechend betitelten Bereich abgerufen.

- Daraus wird ein Teil des gewünschten Bildes erzeugt.

Falls also jemand einen „Hund“ wünscht, kommt — je nach Verhältnis zwischen echten und „falschen“ Hunden im „Hunde“-Bereich — eine Grafik heraus, die mehr wie ein Hund oder mehr wie eine Katze aussieht. Wenn genügend viele falsche Trainingsdaten gefüttert wurden, resultieren ganz schlechte Resultate.

Der KI-Bildgenerator wurde vergiftet.

Neu 2025-04-28: Wahrscheinlich haben Glaze und Nightshade nie wirklich funktioniert. Sagt zumindest ein Preprint mit ETH- und Google-Beteiligung.

Quellen

- Neil Clarke: Block the Bots that Feed „AI“ Models by Scraping Your Web Site, 2023-08-23.

- Benj Edwards: University of Chicago researchers seek to “poison” AI art generators with Nightshade, 2023-10-25, Ars Technica.

- The Glaze Team: What is Glaze?, 2023.

Das Teaserbild ist ein Ausschnitt einer KI-Poisoning-Illustration des Glaze-Teams, via Ars Technica.

Verwandte Artikel von mir

- Webseiten für KI-Crawler sperren?

Mehr Information zu den Sperrmöglichkeiten, inklusive der KI-Vergiftung. - Wie funktioniert ChatGPT?

Ein Einblick in die Technik hinter Sprachmodellen und generativer KI ganz allgemein (kurz: es ist geschreddertes Internet, nach statistischen Mustern neu zusammengesetzt). - Machine Learning: Künstliche Faultier-Intelligenz

Wie funktioniert maschinelles Lernen, inkl. Bilderkennung. - Reproduzierbare KI: Ein Selbstversuch

Eine leichte Einführung in KI-Bildgeneratoren an Beispielen. - Identifikation von KI-Kunst

Wie kann man KI-Kunst erkennen? Was sind die Fehler?

Künstliche Intelligenz

- Persönliche Daten für Facebook-KIMeta – Zuckerbergs Imperium hinter Facebook, WhatsApp, Instagram, Threads etc. – hat angekündigt, ab 27. Mai die persönlichen Daten seiner Nutzer:innen in Europa für KI-Training… Persönliche Daten für Facebook-KI weiterlesen

- «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität ZürichForschende der Uni Zürich haben KI-Bots in ein Forum der Plattform Reddit eingeschleust. Und zwar ohne Wissen der Betreiber:innen und User:innen. In diesem Forum, «ChangeMyView»,… «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität Zürich weiterlesen

- Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView»Wie DNIP.ch am Montag als erstes Medium berichtete, hat eine Forschungsgruppe mit Anbindung zur Universität Zürich mittels KI psychologische Forschung an Menschen durchgeführt, ohne dass… Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView» weiterlesen

- KI-Webseiten petzen und beeinflussenKlar kann man die KI manchmal zu verräterischem Verhalten verleiten. Aber noch einfacher ist es, wenn die Webseite ihre Anweisungen an die KI selbst verrät.

- Können KI-Systeme Artikel klauen?Vor ein paar Wochen hat die NZZ einen Artikel veröffentlicht, in dem Petra Gössi das NZZ-Team erschreckte, weil via KI-Chatbot angeblich «beinahe der gesamte Inhalt… Können KI-Systeme Artikel klauen? weiterlesen

- Was verraten KI-Chatbots?«Täderlät» die KI? Vor ein paar Wochen fragte mich jemand besorgt, ob man denn gar nichts in Chatbot-Fenster eingeben könne, was man nicht auch öffentlich… Was verraten KI-Chatbots? weiterlesen

- KI-DatenkreisläufeHier ein kleiner Überblick über die Datenkreisläufe rund um generative KI, insbesondere grosse Sprachmodelle (Large Language Model, LLM) wie ChatGPT, Gemini oder Claude.

- Der Homo Ludens muss Werkzeuge spielend erfahren. Auch KIFast alle Werkzeuge, die wir «spielend» beherrschen, haben wir spielend gelernt. Das sollten wir auch bei generativer KI.

- Der Turing-Test im Laufe der ZeitVor einem knappen Jahrhundert hat sich Alan Turing mit den Fundamenten der heutigen Informatik beschäftigt: Kryptographie, Komplexität/Rechenaufwand, aber auch, ob und wie wir erkennen könnten,… Der Turing-Test im Laufe der Zeit weiterlesen

- «QualityLand» sagt die Gegenwart voraus und erklärt sieIch habe vor Kurzem das Buch «QualityLand» von Marc-Uwe Kling von 2017 in meinem Büchergestell gefunden. Und war erstaunt, wie akkurat es die Gegenwart erklärt.… «QualityLand» sagt die Gegenwart voraus und erklärt sie weiterlesen

- Kritik an KI ist nötig. Aber wie?KI ist seit 1½ Jahren in aller Munde. Die Meinungen gehen von Woher kommt diese Uneinigkeit? Daran, dass die Kritik an der KI faul geworden… Kritik an KI ist nötig. Aber wie? weiterlesen

- Neuralink ist (noch) keine Schlagzeile wertDiese Woche haben einige kurze Tweets von Elon Musk hunderte oder gar tausende von Artikeln ausgelöst. Wieso?

- Die düsteren Datenhintergründe der KIGenerative Sprachmodelle wie beispielsweise ChatGPT erwecken den Eindruck, Neues zu erzeugen. Dabei kombinieren sie nur Muster neu. Wobei: Diese Kombinationen sind nicht immer wirklich neu.… Die düsteren Datenhintergründe der KI weiterlesen

- «Quasselquote» bei LLM-SprachmodellenNeulich erwähnte jemand, dass man ChatGPT-Output bei Schülern häufig an der «Quasselquote» erkennen könne. Das ist eine Nebenwirkung der Funktionsweise dieser Sprachmodelle, aber natürlich noch… «Quasselquote» bei LLM-Sprachmodellen weiterlesen

- «KI» und «Vertrauen»: Passt das zusammen?Vor einigen Wochen hat Bruce Schneier einen Vortrag gehalten, bei dem er vor der der Vermischung und Fehlinterpretation des Begriffs «Vertrauen» gewarnt hat, ganz besonders… «KI» und «Vertrauen»: Passt das zusammen? weiterlesen

- Wegweiser für generative KI-ToolsEs gibt inzwischen eine grosse Anzahl generativer KI-Tools, nicht nur für den Unterricht. Hier ein Überblick über verschiedene Tool-Sammlungen.

- KI-VergiftungEine aggressive Alternative zur Blockade von KI-Crawlern ist das «Vergiften» der dahinterliegenden KI-Modelle. Was bedeutet das? Viele Daten aus Webseiten, Büchern und Grafiken sind bereits… KI-Vergiftung weiterlesen

- Lehrerverband, ChatGPT und DatenschutzDer Dachverband der Lehrerinnen und Lehrer (LCH) sei besorgt, dass es in der Schweiz keine einheitliche Regelung gäbe, wie Lehrpersonen mit Daten ihrer Schützlinge umgehen… Lehrerverband, ChatGPT und Datenschutz weiterlesen

- «Recht auf Vergessenwerden»: Ende durch KI?Das Recht auf Vergessenwerden soll Menschen erlauben, dass Daten über sie nicht unnötig lange digital gespeichert oder verfügbar gemacht werden. Doch KI vergisst nicht gerne.… «Recht auf Vergessenwerden»: Ende durch KI? weiterlesen

- Webseiten für KI-Crawler sperren?Der grösste Teil der Texte, auf denen moderne KI-Sprachmodelle trainiert wurden, stammen von Webseiten. Wenn Sie eine haben, dann vermutlich auch von Ihrer. Was kann… Webseiten für KI-Crawler sperren? weiterlesen

- KI und die Arbeitswelt der ZukunftMichael Seemann hat in rund 100 sehr gut lesbaren Seiten das Wichtigste zusammengefasst, was wir über ChatGPT & Co wissen. Und ein paar Szenarien für… KI und die Arbeitswelt der Zukunft weiterlesen

- Todesstoss für ChatGPT & Co?Die New York Times verhandelt schon länger mit OpenAI über Urheberrechtsabgaben. Laut Berichten hat OpenAI für das Training von ChatGPT unautorisiert Materialien der New York… Todesstoss für ChatGPT & Co? weiterlesen

- Sinkt OpenAI?Schlagzeilen machen die Runde, dass OpenAI, die Firma hinter ChatGPT, schon nächstes Jahr Konkurs gehen könnte. Ein Versuch einer Analyse.

- Goethe oder GPThe?In «Wie funktioniert ChatGPT?» habe ich die Experimente von Andrej Karpathy mit Shakespeare-Texten wiedergegeben. Aber funktioniert das auch auf Deutsch? Zum Beispiel mit Goethe? Finden… Goethe oder GPThe? weiterlesen

Schreibe einen Kommentar