KI-Kunst ist auf dem Vormarsch, sowohl was die Qualität als auch die Quantität betrifft. Es liegt (leider) in der menschlichen Natur, einiges davon als „echte“, menschgeschaffene Kunst zu vermarkten. Hier sind einige Anzeichen, die helfen können, KI-Kunst zu erkennen.

This article is also available in English 🇬🇧: «Identifying AI Art».

Programme wie DALL•E 2, MidJourney oder StableDiffusion machen es einfach, gut aussehende Bilder zu erstellen. Das Teaser-Bild für diesen Artikel wurde zum Beispiel aus dem herausgeschnitten, was DALL•E 2 zurückgab, als ich es nach etwas fragte, das „KI-Kunst mit einer Lupe untersuchen“ darstellen soll („inspecting ai art with a magnifying glass“).

Sie sehen ziemlich überzeugend aus, nicht? Woran könnten wir erkennen, dass sie nicht von einem menschlichen Künstler gemacht wurden? Hier sind einige Hinweise. Natürlich wird die generative KI mit der Zeit immer besser werden, und auch die menschlichen KI-Betreiber, die versuchen, die KI-Werke als ihre eigenen zu „verkaufen“, werden versuchen, einige dieser Merkmale zu verschleiern.

Auch wenn diese Merkmale sich also mit der Zeit verändern werden, macht es trotzdem Sinn, sie einmal aufzuzählen. Die Beispiele hier sind durch die Miniserie „Reproduzierbare KI-Bilderzeugung“ (Teil 1 auf Deutsch, Teil 2 auf Englisch) illustriert. Da es sich um Bilder handelt, die ihren KI-Ursprung nicht zu verbergen versuchen (weder auf der Prompt- noch auf der Post-Processing-Ebene), eignen sie sich gut als Studienobjekte.

Dieser Beitrag wurde inspiriert von einem (kurzlebigen und inzwischen verschwundenen) Beitrag von menschlichen Digitalkünstler Neobscura [NSFW] inspiriert, wofür ich dankbar bin.

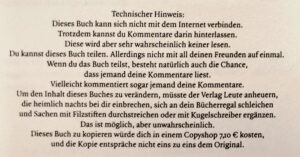

Wasserzeichen

Am offensichtlichsten (und einfachsten zu entfernen) sind Wasserzeichen, die durch Nachbearbeitung in den KI-Dienst eingebettet werden. Bei DALL-E 2 ist zum Beispiel in der rechten unteren Ecke folgendes eingebettet (aus dem Teaser-Bild):

Es ist trivial, das Bild zu beschneiden oder manuell zu rekonstruieren, was sich darunter befinden könnte. Erwarten Sie also nicht, dass ein „Fälscher“ das drin lässt.

[Neu 2023-09-24] Je nach System sind auch Marken vorhanden, die nicht direkt ersichtlich sind. So fügt DALL•E 2 zwei EXIF-Felder in den Metadaten, „OpenAI--ImageGeneration--generation-<zufällig aussehende Zeichenfolge>“ und „Made with OpenAI Labs„. Auch diese können absichtlich oder unabsichtlich beim Bearbeiten entfernt werden. (Die Bilder hier und hier können als Beispiele dienen. Die Original-PNG-Bilder, in denen die Informationen eingebettet sind, erscheinen durch Klick auf die Miniaturbilder.)

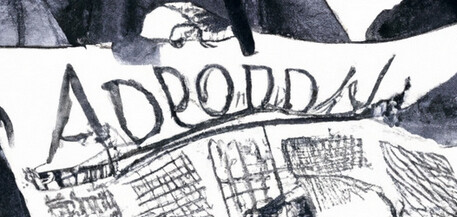

Text

Auf den obigen Bildern „Inspektion von KI-Kunst“ ist der Text erstaunlich klar (vermutlich wurde versucht, ein kombiniertes Wort aus „AI“ und „Art“ zu bilden). Oft ist der Text jedoch bestenfalls sehr grob. Selbst wenn die Zeichen erkennbar sind, sind die Umrisse oft gezackt.

Je nach Kontext kann die Schrift (durch Prompt oder Nachbearbeitung) auch leicht geändert werden. Und wahrscheinlich werden KI-Kunstplattformen in Zukunft lernen, besser mit Text umzugehen.

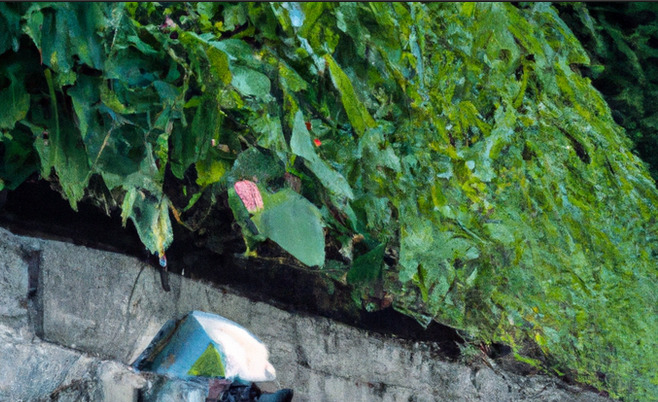

Unmotiviertes Rauschen oder Detail

Ein generiertes Bild basiert im Wesentlichen auf einer Collage aus verschiedenen Quellen. Daher werden in der Regel Quellen unterschiedlicher Stile verwendet, auch wenn dies teilweise über die Eingabeaufforderung gesteuert werden kann. Einige dieser Stilunterschiede schaffen es in das Zielbild, wo sie ihren KI-Ursprung verraten können: Auflösung, Glätte, Vorhandensein/Härte/Auflösung von Texturen und mehr.

Wann immer es unmotivierte Veränderungen in der Feinstruktur des Bildes gibt, ist das ein guter Hinweis auf KI-Kunst. Einiges davon kann natürlich durch Glättungs- oder Verpixelungsfilter verdeckt werden.

Feinstruktur gegen Grobstruktur

Das Heranzoomen von Details kann zeigen, dass ein Gegenstand nicht das ist, was er zu sein vorgibt: Bäume, die nicht aus Blättern der richtigen Grösse oder Art bestehen, Schindeln auf dem Dach, die eigentlich Ziegel sind, … Wie beim „unaufgeforderten Rauschen oder Detail“ oben ist die KI im Wesentlichen eine Copy-Paste-Operation auf Steroiden und nicht ein kohärenter Bildgenerator. Mit all‘ den Problemen, die Copy-Paste mit sich bringt.

Solche Anzeichen sind wahrscheinlich schwer (halb-)automatisch zu entfernen und wahrscheinlich ein gutes Indiz, dass etwas mit dem Bild nicht stimmt.

Mangel an Symmetrie

Nur weil etwas in der realen Welt symmetrisch ist, ist das noch lange kein Grund für die KI, Symmetrie zu generieren.

Das kann wohl nur mit händischer Korrektur oder Nachzeichnenlassen durch die KI („inpainting“). Aber auch hier werden die Generatoren mit der Zeit besser werden.

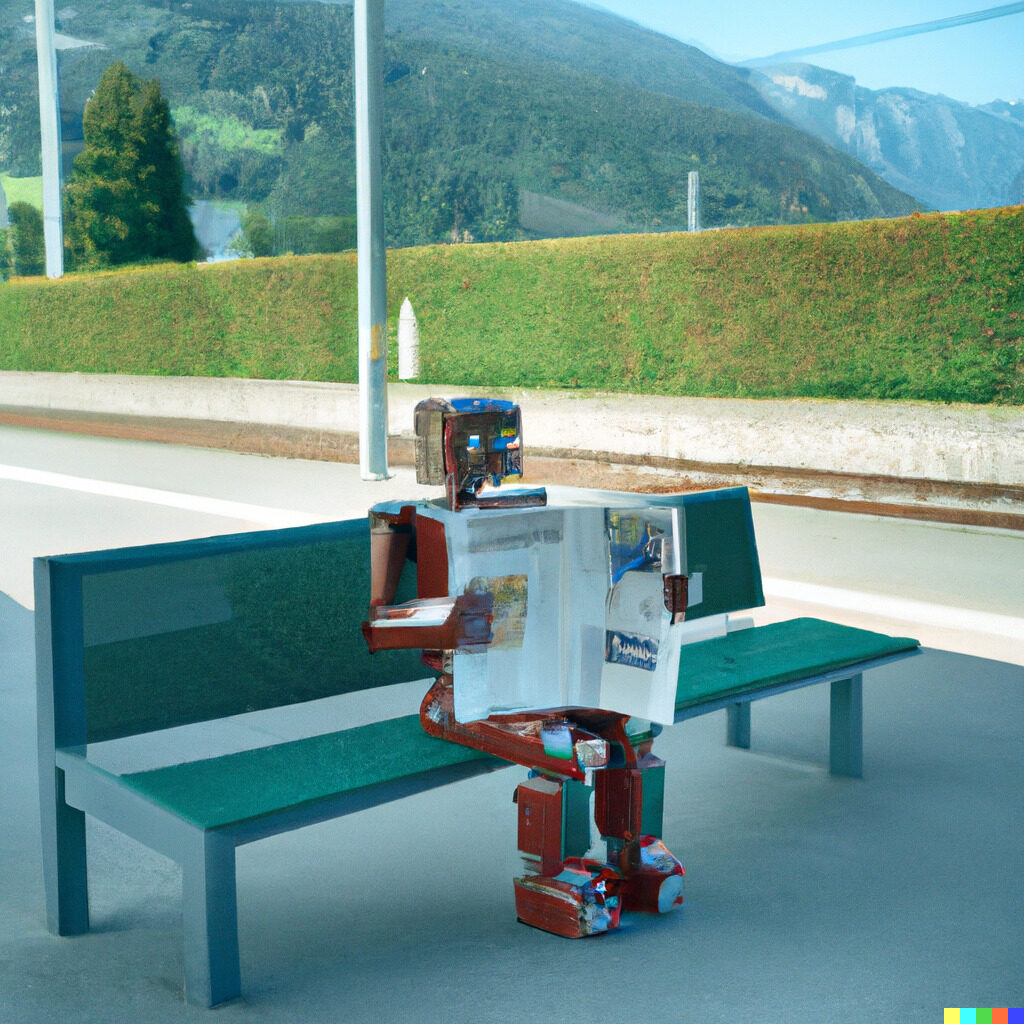

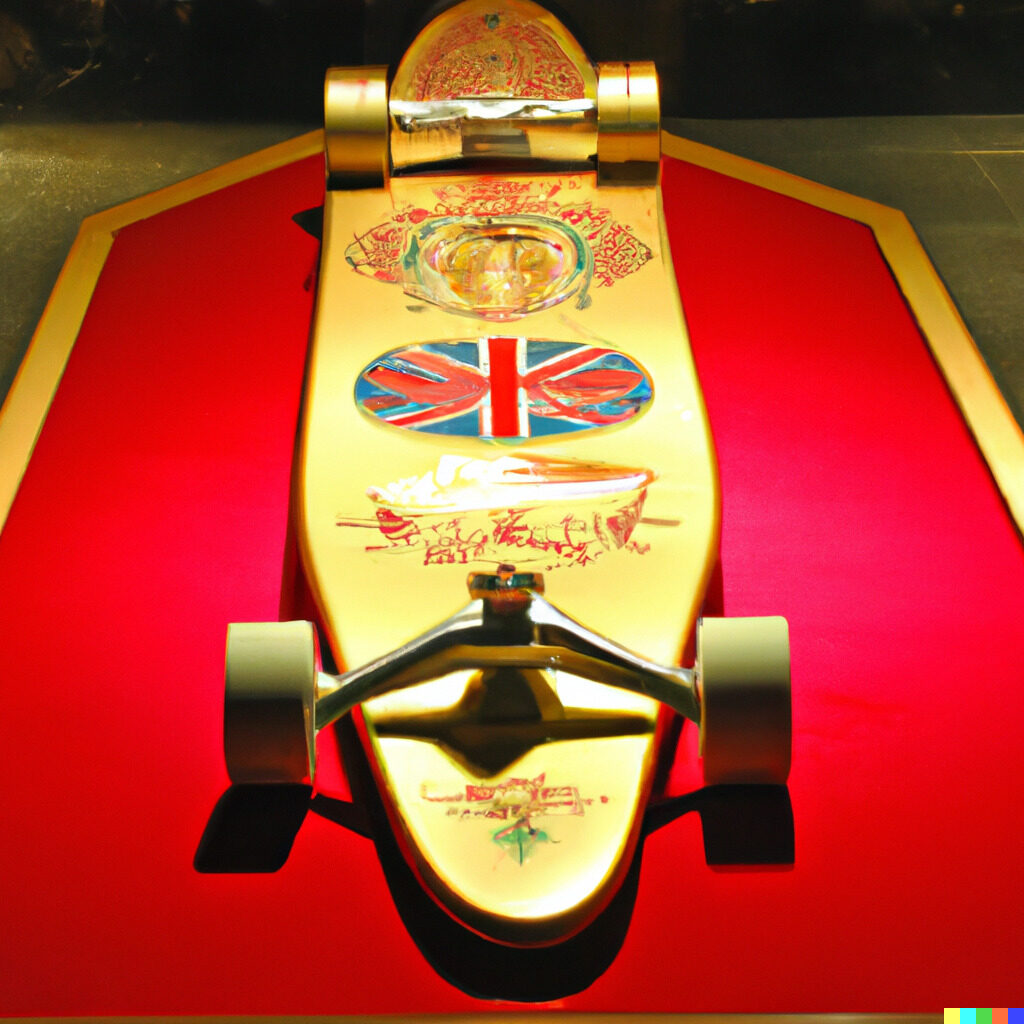

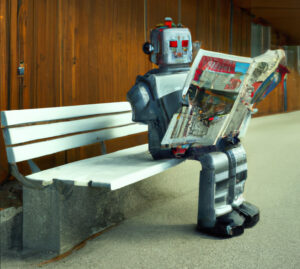

Unmögliches in 3D

Aktuelle KI-Bildgeneratoren haben noch keine echte Kenntnis über den 3D-Raum. Deshalb findet sich in den generierten KI-Bildern „innovative“ Geometrie. Besonders Bänke und Mechanik haben sich bei mir als zu kompliziert für die KI herausgestellt.

Diese Probleme können mit zusätzlichen Versuchen oder Änderung des Prompts wahrscheinlich korrigiert werden. Ganz besonders hier wird sich in den nächsten Monaten noch viel ändern: Bereits jetzt gibt es erste Möglichkeiten, KI-Kunst auf 3D-Modelle zu projizieren oder 3D-Modelle zu generieren.

Licht und Schatten

Fehlerhafte Reflexionen und Schatten sind gute Indikatoren für manipulierte („geshoppte“) Bilder. ein gutesThese are known to help identifying manipulated photos. And remain friends when identifying AI generated art.

Auch dies wird sich wahrscheinlich anlässlich der Einführung von echten 3D-Szenen in die Bildgenerierungspipeline verbessern.

Augen und Haare

Augen, die nicht in die gleiche Richtung blicken, verzerrte Augenformen oder unnatürliches Haar sind gute Indizien für Bilder, die durch eine KI erzeugt wurden. Die Augen von Tieren scheinen besonders empfänglich für Fehler zu sein, wahrscheinlich eine Folge der knapperen Trainingsdaten.

Insbesondere menschliche Augen, Haare und Gesichter werden wohl noch fleissig getunt werden; diese Aspekte werden zukünftig also seltener als Indizien herhalten können.

Gliedmassen und Finger

Von Kinder- und Comic-Zeichnungen kennt man das, dass die Anzahl Arme, Beine oder Finger nicht mit unserer täglichen Erfahrung übereinstimmt. Seitliche Ansichten von Vierbeinern würden häufig Zählfehler aufweisen, was sich aber mit den ausgewählten Bildern nicht verifizieren liess.

Mittels Inpainting kann das wahrscheinlich häufig korrigiert werden; es hilft auch, wenn nichts Ungewöhnliches neben den Gliedmassen gezeichnet werden soll. Auch das wird wohl mit besserem Training weniger auffällig werden.

[Hinzugefügt 2023-02-04:] Das „bessere Training“ dürfte aus drei Dingen bestehen:

- Mehr und grössere Hände in den Bildern

- Hände „alleine“ (also auf ruhigem Hintergrund und ohne dass sie etwas/jemanden umfassen)

- Hände aus verschiedenen Blickwinkeln

Zusammenfassung

Vieles kann bei der KI-Bildgenerierung schief gehen; ein genauer Blick lohnt sich. Natürlich kann es auch falsch positive Beurteilungen geben (ein echter menschlicher Digitalkünstler hat das Bild erstellt, war aber nachlässig oder hat das absichtlich als Stilelement genutzt); genau wie auch falsch negative (die KI-Kunst ist zufällig gut genug oder durch genügend viele Iterationen, Inpainting oder Nachbearbeitung gut genug gemacht worden).

Literatur

- Sarah Shaffi: ‘It’s the opposite of art’: Why illustrators are furious about AI, The Guardian, 2023-01-23.

- Shira Ovide: How to spot the Trump and Pope AI fakes, The Washington Post, 2023-03-31. [Neu 2023-12-17]

- KI: AfD Göppingen wirbt mit einem Fake-Gesicht, Tagesschau.de, 2024-03-21. Fehler bei gtossen Gesichtern erkennen.

- Bildmanipulation, umgangssprachlich „photoshopping“, kann teilweise zu ähnlichen Fehlern führen. Eine Internetsuche nach „Bildmanipulation erkennen“, „Foto-Forensik“ oder ähnlichen Ausdrücken liefert eine Unzahl an Empfehlungen und Werkzeugen.

Künstliche Intelligenz

- Persönliche Daten für Facebook-KIMeta – Zuckerbergs Imperium hinter Facebook, WhatsApp, Instagram, Threads etc. – hat angekündigt, ab 27. Mai die persönlichen Daten seiner Nutzer:innen in Europa für KI-Training zu verwenden. Dazu gehören alle… Persönliche Daten für Facebook-KI weiterlesen

- «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität ZürichForschende der Uni Zürich haben KI-Bots in ein Forum der Plattform Reddit eingeschleust. Und zwar ohne Wissen der Betreiber:innen und User:innen. In diesem Forum, «ChangeMyView», fordern die Teilnehmenden dazu auf,… «Reddit rAIngelegt»: Hörkombinat-Podcast-Interview zur fragwürdigen KI-Manipulation an der Universität Zürich weiterlesen

- Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView»

Wie DNIP.ch am Montag als erstes Medium berichtete, hat eine Forschungsgruppe mit Anbindung zur Universität Zürich mittels KI psychologische Forschung an Menschen durchgeführt, ohne dass diese Menschen über die Studie… Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView» weiterlesen

Wie DNIP.ch am Montag als erstes Medium berichtete, hat eine Forschungsgruppe mit Anbindung zur Universität Zürich mittels KI psychologische Forschung an Menschen durchgeführt, ohne dass diese Menschen über die Studie… Forschung am Menschen ohne deren Wissen: Universität Zürich und Reddit «r/ChangeMyView» weiterlesen - KI-Webseiten petzen und beeinflussen

Klar kann man die KI manchmal zu verräterischem Verhalten verleiten. Aber noch einfacher ist es, wenn die Webseite ihre Anweisungen an die KI selbst verrät.

Klar kann man die KI manchmal zu verräterischem Verhalten verleiten. Aber noch einfacher ist es, wenn die Webseite ihre Anweisungen an die KI selbst verrät. - Können KI-Systeme Artikel klauen?

Vor ein paar Wochen hat die NZZ einen Artikel veröffentlicht, in dem Petra Gössi das NZZ-Team erschreckte, weil via KI-Chatbot angeblich «beinahe der gesamte Inhalt des Artikels […] in der… Können KI-Systeme Artikel klauen? weiterlesen

Vor ein paar Wochen hat die NZZ einen Artikel veröffentlicht, in dem Petra Gössi das NZZ-Team erschreckte, weil via KI-Chatbot angeblich «beinahe der gesamte Inhalt des Artikels […] in der… Können KI-Systeme Artikel klauen? weiterlesen - Was verraten KI-Chatbots?«Täderlät» die KI? Vor ein paar Wochen fragte mich jemand besorgt, ob man denn gar nichts in Chatbot-Fenster eingeben könne, was man nicht auch öffentlich teilen würde. Während der Erklärung… Was verraten KI-Chatbots? weiterlesen

- KI-DatenkreisläufeHier ein kleiner Überblick über die Datenkreisläufe rund um generative KI, insbesondere grosse Sprachmodelle (Large Language Model, LLM) wie ChatGPT, Gemini oder Claude.

- Der Homo Ludens muss Werkzeuge spielend erfahren. Auch KI

Fast alle Werkzeuge, die wir «spielend» beherrschen, haben wir spielend gelernt. Das sollten wir auch bei generativer KI.

Fast alle Werkzeuge, die wir «spielend» beherrschen, haben wir spielend gelernt. Das sollten wir auch bei generativer KI. - Der Turing-Test im Laufe der Zeit

Vor einem knappen Jahrhundert hat sich Alan Turing mit den Fundamenten der heutigen Informatik beschäftigt: Kryptographie, Komplexität/Rechenaufwand, aber auch, ob und wie wir erkennen könnten, ob Computer „intelligent“ seien. Dieses… Der Turing-Test im Laufe der Zeit weiterlesen

Vor einem knappen Jahrhundert hat sich Alan Turing mit den Fundamenten der heutigen Informatik beschäftigt: Kryptographie, Komplexität/Rechenaufwand, aber auch, ob und wie wir erkennen könnten, ob Computer „intelligent“ seien. Dieses… Der Turing-Test im Laufe der Zeit weiterlesen - «QualityLand» sagt die Gegenwart voraus und erklärt sie

Ich habe vor Kurzem das Buch «QualityLand» von Marc-Uwe Kling von 2017 in meinem Büchergestell gefunden. Und war erstaunt, wie akkurat es die Gegenwart erklärt. Eine Leseempfehlung.

Ich habe vor Kurzem das Buch «QualityLand» von Marc-Uwe Kling von 2017 in meinem Büchergestell gefunden. Und war erstaunt, wie akkurat es die Gegenwart erklärt. Eine Leseempfehlung. - Kritik an KI ist nötig. Aber wie?

KI ist seit 1½ Jahren in aller Munde. Die Meinungen gehen von Woher kommt diese Uneinigkeit? Daran, dass die Kritik an der KI faul geworden sei und nur noch wiederkäue,… Kritik an KI ist nötig. Aber wie? weiterlesen

KI ist seit 1½ Jahren in aller Munde. Die Meinungen gehen von Woher kommt diese Uneinigkeit? Daran, dass die Kritik an der KI faul geworden sei und nur noch wiederkäue,… Kritik an KI ist nötig. Aber wie? weiterlesen - Neuralink ist (noch) keine Schlagzeile wert

Diese Woche haben einige kurze Tweets von Elon Musk hunderte oder gar tausende von Artikeln ausgelöst. Wieso?

Diese Woche haben einige kurze Tweets von Elon Musk hunderte oder gar tausende von Artikeln ausgelöst. Wieso? - Die düsteren Datenhintergründe der KI

Generative Sprachmodelle wie beispielsweise ChatGPT erwecken den Eindruck, Neues zu erzeugen. Dabei kombinieren sie nur Muster neu. Wobei: Diese Kombinationen sind nicht immer wirklich neu. Mit ein bisschen Geschick kann… Die düsteren Datenhintergründe der KI weiterlesen

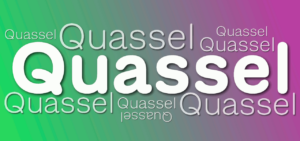

Generative Sprachmodelle wie beispielsweise ChatGPT erwecken den Eindruck, Neues zu erzeugen. Dabei kombinieren sie nur Muster neu. Wobei: Diese Kombinationen sind nicht immer wirklich neu. Mit ein bisschen Geschick kann… Die düsteren Datenhintergründe der KI weiterlesen - «Quasselquote» bei LLM-Sprachmodellen

Neulich erwähnte jemand, dass man ChatGPT-Output bei Schülern häufig an der «Quasselquote» erkennen könne. Das ist eine Nebenwirkung der Funktionsweise dieser Sprachmodelle, aber natürlich noch kein Beweis. Etwas Hintergrund.

Neulich erwähnte jemand, dass man ChatGPT-Output bei Schülern häufig an der «Quasselquote» erkennen könne. Das ist eine Nebenwirkung der Funktionsweise dieser Sprachmodelle, aber natürlich noch kein Beweis. Etwas Hintergrund. - «KI» und «Vertrauen»: Passt das zusammen?

Vor einigen Wochen hat Bruce Schneier einen Vortrag gehalten, bei dem er vor der der Vermischung und Fehlinterpretation des Begriffs «Vertrauen» gewarnt hat, ganz besonders beim Umgang mit dem, was… «KI» und «Vertrauen»: Passt das zusammen? weiterlesen

Vor einigen Wochen hat Bruce Schneier einen Vortrag gehalten, bei dem er vor der der Vermischung und Fehlinterpretation des Begriffs «Vertrauen» gewarnt hat, ganz besonders beim Umgang mit dem, was… «KI» und «Vertrauen»: Passt das zusammen? weiterlesen

Schreibe einen Kommentar